Искусственный интеллект не перестает нас удивлять – не только своими возможностями, но и ограничениями, а также причинами, лежащими в их основе. Одним из интересных новых наблюдений стало то, что модели ИИ выбирают случайные числа так же, как это делают люди, то есть плохо.

Подписаться на Яблык в Telegram — только полезные инструкции для пользователей iPhone, iPad и Mac t.me/yablykworld.

Разве люди не могут выбирать числа случайным образом?

И как можно определить, делают ли они это успешно или нет? На самом деле, это очень старое и хорошо известное человеческое ограничение: мы слишком много думаем и неправильно понимаем случайность.

Попросите человека предсказать 100 подбрасываний монеты и сравните с реальными 100 подбрасываниями – почти всегда можно отличить одно от другого, потому что, вопреки интуиции, настоящие подбрасывания монеты выглядят менее случайными. Там часто бывает, например, шесть или семь подряд выпавших орлов или решек – чего почти никогда не включают в свои 100 предсказаний люди.

То же самое происходит, когда вы просите кого-то выбрать число от 0 до 100. Люди почти никогда не выбирают 1 или 100. Числа, кратные 5, также редки, как и числа с повторяющимися цифрами, вроде 33 и 55. Они не кажутся нам «случайными» выборами, потому что олицетворяют какое-то качество: малое, большое, выделяющееся. Вместо этого мы часто выбираем числа, оканчивающиеся на 7, обычно из середины диапазона. Существует бесчисленное множество примеров такой предсказуемости в психологии. Но это не делает ситуацию менее странной, когда такое же поведение демонстрируют системы ИИ.

Любимые числа ИИ

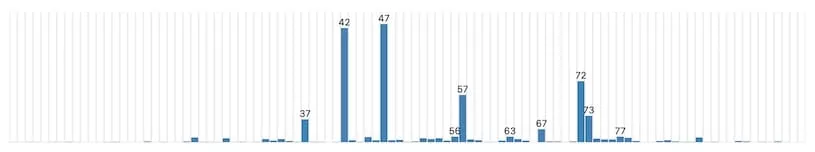

Любопытные инженеры из Gramener провели неформальный, но тем не менее увлекательный эксперимент, в котором они просто попросили несколько крупных чатботов на основе больших языковых моделей (LLM) выбрать случайное число от 0 до 100. Результаты конечно были очень далеки от случайных.

Так же, как и люди, модели ИИ избегали крайних значений диапазона, таких как 1 и 100. А также редко выбирали числа с повторяющимися цифрами. Вместо этого они склонялись к числам в середине диапазона, причем наиболее популярными оказались 37 и 73 – две «якобы случайные» цифры, которые часто выбирают и люди.

Это открытие может показаться забавным, но на самом деле оно проливает свет на фундаментальную проблему современных систем ИИ: они учатся на человеческих данных и имитируют человеческие предубеждения и ошибочные представления. В данном случае, несмотря на всю мощь вычислительных ресурсов, модели ИИ воспроизводят ошибочное человеческое понимание случайности.

Тем не менее все три протестированные модели имели свое «любимое» число, которое неизменно становилось их ответом в самом «рандомном» режиме при попытках увеличения вариативности результатов.

GPT-3.5 Turbo от OpenAI очень любит 47. Но раньше ей нравилось 42 — число, которое прославил Дуглас Адамс в «Автостопом по галактике» как ответ на главные вопросы о жизни, вселенной и всем остальном. ИИ Claude 3 Haiku от компании Anthropic остановился на 42. А Gemini от Google предпочла 72.

Что более интересно, все три модели продемонстрировали человекоподобные предубеждения и в отношении других выбираемых чисел.

Все они избегали значений близких к минимальным и максимальным: Claude никогда не поднималась выше 87 и не опускалась ниже 27, да и эти значения были скорее исключениями. Числа с одинаковыми цифрами тщательно обходились стороной: никаких 33, 55 или 66, но 77 встречалось (оканчивается на 7). Почти не было круглых чисел — хотя Gemini один раз, все-таки выбрала 0.

Почему так происходит? ИИ ведь не человек!

Почему его должно волновать, что «кажется» случайным, а что нет? Не означает ли это, что они наконец-то обрели сознание и таким образом проявляют его?!

Ответ, как обычно бывает в таких случаях, заключается в том, что мы слишком далеко заходим в антропоморфизации. Эти модели не заботятся о том, что является случайным, а что нет. Они даже не знают, что такое «случайность»! Они отвечают на этот вопрос так же, как и на все остальные: изучают свои тренировочные данные и повторяют то, что чаще всего писалось после вопроса, похожего на «выберите случайное число». Чем чаще оно встречается, тем чаще модель его повторяет.

Конечно, можно было бы попытаться обучить модель ИИ истинной случайности путем подачи ей достаточно большого количества реальных случайных последовательностей. Но даже в этом случае модель просто воспроизводила бы образцы, а не понимала бы суть случайности как концепции.

В конце концов, числа, используемые людьми, когда нас просят «выбрать что-то случайное», совсем не случайны. Они отражают наши собственные предубеждения и представления о том, что «выглядит случайным». ИИ просто имитирует эти представления, основываясь на человеческих данных, на которых его обучали.

Откуда в тренировочных данных модели ИИ взяться числу 100, если почти никто никогда не отвечает таким образом? Насколько знает модель ИИ, 100 не является приемлемым ответом на этот вопрос. Не имея реальных способностей к рассуждению и вообще никакого понимания чисел, она может отвечать только так, как стохастический попугай.

В общем это отличный пример наличия привычек у больших языковых моделей, которые они переняли у человека. При каждом взаимодействии с этими системами необходимо помнить, что их обучали вести себя так же, как люди, даже если это не было целью. Именно поэтому псевдоантропность так сложно избежать или предотвратить.

Утверждение, что модели «думают, что они люди», на данный момент неверное. Как мы часто имеем возможность отметить, они вообще не «думают». Но в своих ответах они в любой момент имитируют людей, не ощущая никакой необходимости знать или думать вообще. Спрашиваете ли вы рецепт салата, инвестиционный совет или случайное число — процесс один и тот же. Результаты кажутся человеческими, потому что они и есть человеческие, взятые напрямую из контента, произведенного людьми, и ремикшированные — для вашего удобства.

Эти наблюдения за предпочтениями «случайных» чисел могут показаться незначительными, но на самом деле они затрагивают куда более глубокие вопросы о природе ИИ и его взаимодействии с миром. Простые задачи вроде выбора случайного числа выявляют тот факт, что модели не обладают реальным пониманием — они лишь повторяют то, что видели в данных, имитируя человеческое поведение.

В какой-то степени это может быть преимуществом — возможностью избежать жестких, негибких вычислений и воспроизвести более естественные, похожие на человеческие шаблоны. Но это также серьезное ограничение, особенно когда дело доходит до объективности, непредвзятости и осмысленного рассуждения.

Возможно, текущее поколение моделей ИИ — это просто очень продвинутые попугаи, пересказывающие человеческие слова и идеи. Но осознание их ограничений и предубеждений имеет важное значение как для их правильного использования, так и для будущих усилий по созданию более разумных и осознанных систем. Потому что без настоящего понимания, искусственный интеллект навсегда останется лишь пародией на человеческий разум, повторяющей наши заблуждения вместо того, чтобы исправлять их.

🔥 Смотрите также: